SEO et métas descriptions : Castorama ou Leroy Merlin ?

22 Nov

Avant de parler des Métas descriptions des deux géants français du bricolage, voici un bref rappel sur le CTR.

Votre CTR est votre taux de clics, (la somme de tous les clics sur une annonce donnée (ici votre titre de site + sa description + l’url)/la somme des affichages d’un même site) x 100 pour un résultat donné de la page de résultats d’une requête de l’internaute (la fameuse SERP).

Google prend en compte le CTR dans la même mécanique que vos campagnes Adwords. Si la description est assez incitative et en rapport avec les mots clés tapés par l’internaute (en tous cas, suffisamment pour que l’internaute clique dessus), alors votre CTR va avoir tendance à augmenter et votre position pour ce mot clé également (pas seulement grâce à cela, Google prend en compte des centaines de critères dans le référencement naturel, pour plus d’informations et d’idées d’optimisations, je vous invite à consulter les guidelines Google).

Même si vous arrivez à trouver la meilleure phrase d’accroche de tous les temps, avec un CTR que vous jugez suffisant, il est quand même nécessaire de varier pour éviter la pénalisation car Google veille au grain ! La duplication de contenus vous guette. Il est également important de rester dans une démarche de test et d’amélioration continue pour espérer être le meilleur sur votre créneau.

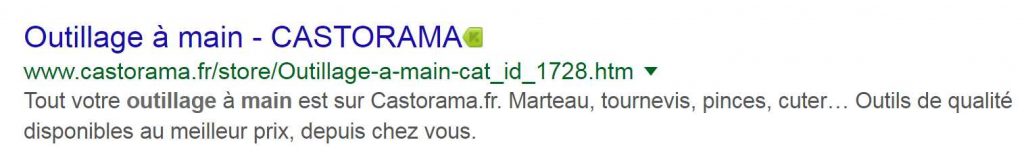

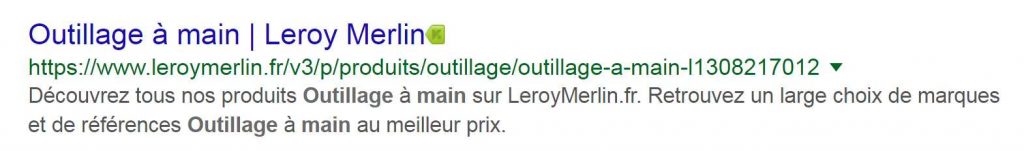

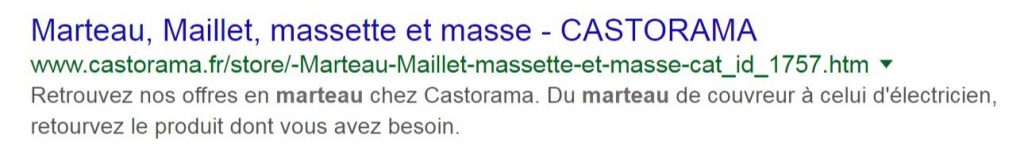

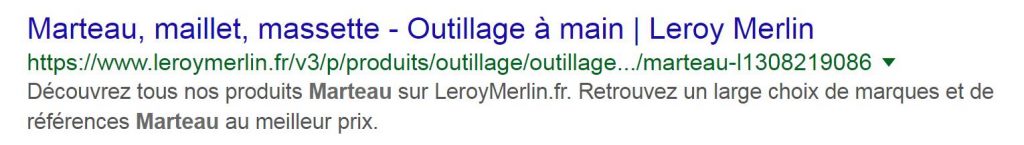

A votre avis lequel des deux sites obtiendra un meilleur CTR à long terme ? Celui avec des métas descriptions répétitives qui respectent toutes un même modèle ou bien celui qui propose une méta originale, réfléchie et adaptée pour l’utilisateur pour chaque expression donnée ? L’exemple le plus frappant reste celui des marteaux 😉

NB: attention aux coquilles dans vos descriptions, l’internaute est de plus en plus tatillon.

Attention également à certaines descriptions trop longues pour être affichées entièrement, par exemple ici :

Enfin, ceci n’est qu’une partie émergée de l’iceberg en effet, le site de Castorama ne bénéficie pas à date d’une bonne optimisation pour mobile. Google en a pourtant fait l’une de ses priorités en lançant Mobile First (déploiement prévu sur 5 ans), ce qu’a bien compris Leroy Merlin.

L’outil pagespeed insights donne en effet la note de 74/100 à Leroy Merlin, contre 40/100 à Castorama.

A bientôt pour une nouvelle brève revue SEO ou SEA.